01.成果简介

动作捕捉技术(motion capture)在影视、体育、安防等领域具有广泛应用。传统的动作捕捉分为两大类,光学动捕系统通过在采集环境部署多个红外摄像头,再在人员的动捕服上放置光学标记球来求解出采集者的姿态信息,从而实现对人体运动的捕捉与动画映射;惯性动捕系统通过惯性测量单元(IMU)来采集肢体的运动信息,采集设备相对更轻便,但采集精度不如光学动捕系统。光学动捕系统包括Motion Analysis,Vicon,Optitrack等,惯性动捕系统有Xsens,诺亦腾等。

然而,无论是光学动捕还是惯性动捕都需要动作人穿上特定的设备,不可避免地会影响到人体运动的真实性和动捕的使用范围。同时,相应的专业动捕设备往往价格不菲,很多有需求的小型工作室也会望而却步。因此,学术界和工业界都在极力研究“无标记运动捕捉”技术,即不需要任何穿戴设备,仅由相机观测和算法分析,就实现对多人体运动的实时准确捕捉。这种技术有着更加广泛的应用场景,例如无人售货超市、VR/AR游戏、远程全息通讯、数字人创建、虚拟主播、人机交互、全天候医疗监护等。

近几年,随着深度学习技术的广泛普及,无标记动捕领域也诞生了许多革命性技术,例如实时2D多人体关键点检测技术OpenPose等。然而,多目标实时3D运动捕捉仍然是一个极具挑战性的问题,主要挑战因素包括:如何实现实时计算,如何进行高效的多视角关联,如何解决紧密交互带来的观测失真等。举个例子,当两个人拥抱在一起的时候,当前大多数检测或重建算法都会失效。而理论上,多视角的观测信号能够在一定算法设计下互相补充,尽可能解决单视角运动重建的歧义性。如何充分利用多视角的视频信号,实现复杂、紧密交互场景下的多人体运动捕捉是当前无标记运动捕捉领域的核心问题之一。

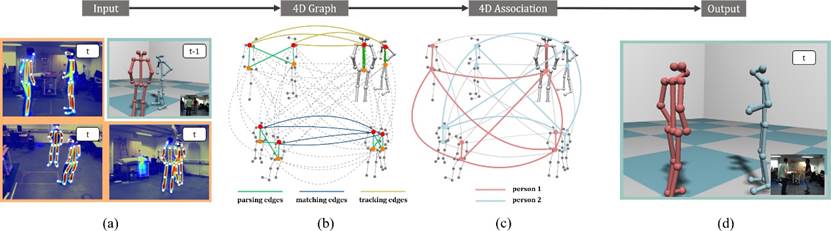

该项目研究工作提出的多视角人体运动捕捉系统包括相机采集模块,2D姿态检测模块,4D关联图求解模块,三维骨架求解模块及渲染模块。其主要算法贡献在于提出并实现了4D Association算法。

图1.算法流程图

当前的多视角运动捕捉系统大多采用的是序贯地匹配策略,首先对每个视角进行独立的人体检测和连接(例如,OpenPose检测关键点和关键点相互连接的概率,从而对人体进行连接;Mask-RCNN、AlphaPose和HRNet都需要先检测每个人的BoundingBox,然后对每个人进行独立的人体检测),然后对人体进行多视角关联和姿态求解,最后进行时域跟踪。这种常规方法的缺陷在于,当单个视角检测失败以后,后续的算法难以对失败的检测结果进行修正,从而将错误的检测传递到下一个步骤,影响跟踪效果,对于紧密交互(例如前文提到的两人拥抱)的情形,单视角的往往很难给出令人满意的检测结果,因此基于序贯式的算法一般会失效。

相较而言,该研究工作的创新性在于充分利用单图连接(2D)、多视角连接(1D)、和时域连接(1D)之间的相互约束从而进行全局优化,用多视角信息和时域信息来避免单视角连接的歧义性,同时也通过单视角连接结果来优化多视角的匹配,从而使得关联结果更趋向于全局最优。具体地,该研究工作提出了一种4D Graph的图结构,将上一帧的三维人体关键点(在初始帧或者人进入动捕范围的时候可以缺失,不影响算法的运行)和当前每一视角的2D关键点建模在同一个图结构中,用单图连接、多视角连接、时域连接的概率作为边的权值,将人体多视角关联的问题看成提取有效边的过程。为了快速地求解这个问题,进一步提出了一种基于完全子图的近似求解算法,高效地完成了从4D图结构中提出正确的人体连接。

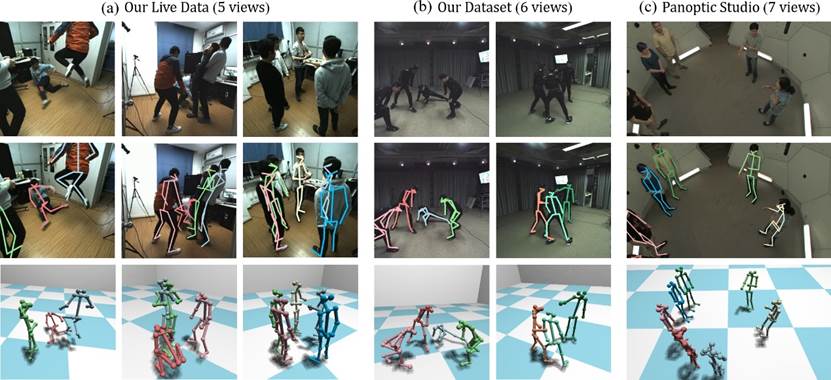

最终,该研究工作实现了紧密交互下人体的三维姿态重建,并展示了实时系统效果。其算法在多个数据集上均表现出了良好的视觉效果,在Shelf数据集上也取得了当前最好的数值结果。

图2.系统输出结果,从上至下:输入图片,三维人体重建,三维可视化

02.应用前景

该项目成果在影视、体育、安防等产业具有广泛的应用前景。

03.知识产权

团队已在该研究方向申请国内外专利20余项。

04.团队介绍

该项目团队长期以来对动态场景重建技术进行了十余年的研究,所提三维重建方法在国际权威评测中,精度指标连续七年排名第一,在高精度场景动态三维重建、三维运动捕捉、计算摄像等方面取得国际领先成果,获得2012年国家技术发明一等奖。该项目课题负责人已发表PAMI论文6篇,SIGGRAPH论文5篇,CVPR/ICCV/ECCV论文22篇,其中口头报告论文6篇,受20余位欧美院士及近百位Fellow引用。项目团队包括教授、副教授各1人,团队成员还包括副教授1人、助理教授1人、博士生4人,其中副教授/助理教授均为优青。

05.合作方式

专利许可。

06.联系方式

邮箱:liuyi2017@tsinghua.edu.cn

注:转载请注明出处。